Assalamualaikum dan hai semua pembaca setia blog saya! Pernah tak korang rasa macam data yang kita ada tu tak cukup untuk buat projek AI yang betul-betul ‘wow’ atau untuk hasilkan analisis yang super tepat?

Dalam zaman di mana kecerdasan buatan (AI) makin maju dan jadi bualan utama, masalah kekurangan data berkualiti ni memang selalu menghantui ramai, termasuklah saya sendiri bila mula-mula dulu.

Kita tahu, model AI yang canggih perlukan banyak ‘makanan’ data untuk belajar, tapi nak kumpul dan label semua tu bukan mudah dan makan masa, kadang-kadang siap kena keluar belanja besar lagi.

Dulu, saya pun pening juga fikirkan macam mana nak atasi hal ini tanpa perlu pecah tabung. Tapi, jangan risau sebab ada satu ‘rahsia’ yang ramai pakar AI dah gunakan untuk buatkan data sedia ada jadi lebih ‘kaya’ dan serbaguna.

Teknik ni bukan saja dapat bantu model AI kita jadi lebih pintar dan tak mudah ‘tersilap faham’ dengan data baru, malah boleh jimatkan banyak masa dan tenaga tau.

Bayangkan, dengan data yang sikit pun, kita boleh latih AI kita jadi champion! Ini adalah trend masa depan yang sangat penting, terutama untuk bisnes-bisnes kecil dan sederhana di Malaysia yang nak ikut arus digitalisasi tanpa modal data yang terlalu besar.

Saya dah cuba dan memang nampak hasilnya. Jom kita kupas tuntas dalam artikel di bawah!

Kenapa ‘Makan’ Data Tak Cukup Untuk AI Kita? Mari Kita Bongkar!

Korang mesti perasan kan, model AI ni macam budak-budak yang baru belajar. Makin banyak ‘buku’ yang dia baca, makin pandai la dia. Dalam konteks AI, ‘buku’ tu adalah data. Kalau data yang kita bagi sikit sangat, macam mana dia nak buat keputusan yang tepat? Pengalaman saya sendiri, bila saya latih model AI dengan set data yang kecil, hasilnya memang tak konsisten. Kadang tepat, kadang meleset jauh. Rasa frust tu memang ada! Ini bukan saja melambatkan projek, tapi juga boleh buat kita hilang keyakinan pada sistem AI yang kita bina. Kita nak AI yang boleh berfungsi dalam pelbagai situasi, bukan sekadar di makmal saja. Realitinya, nak dapatkan data yang banyak dan relevan untuk setiap senario tu memang mencabar, lebih-lebih lagi bila kita berhadapan dengan data-data khusus atau niche. Contohnya, untuk segmen pasaran di Malaysia yang mungkin ada dialek atau budaya tersendiri, data sedia ada di peringkat global mungkin tak cukup tepat. Kita perlukan sesuatu yang boleh ‘kembangkan’ data yang sedia ada ini.

Bila AI ‘Lapar’: Kenapa Kuantiti Data Penting Sangat?

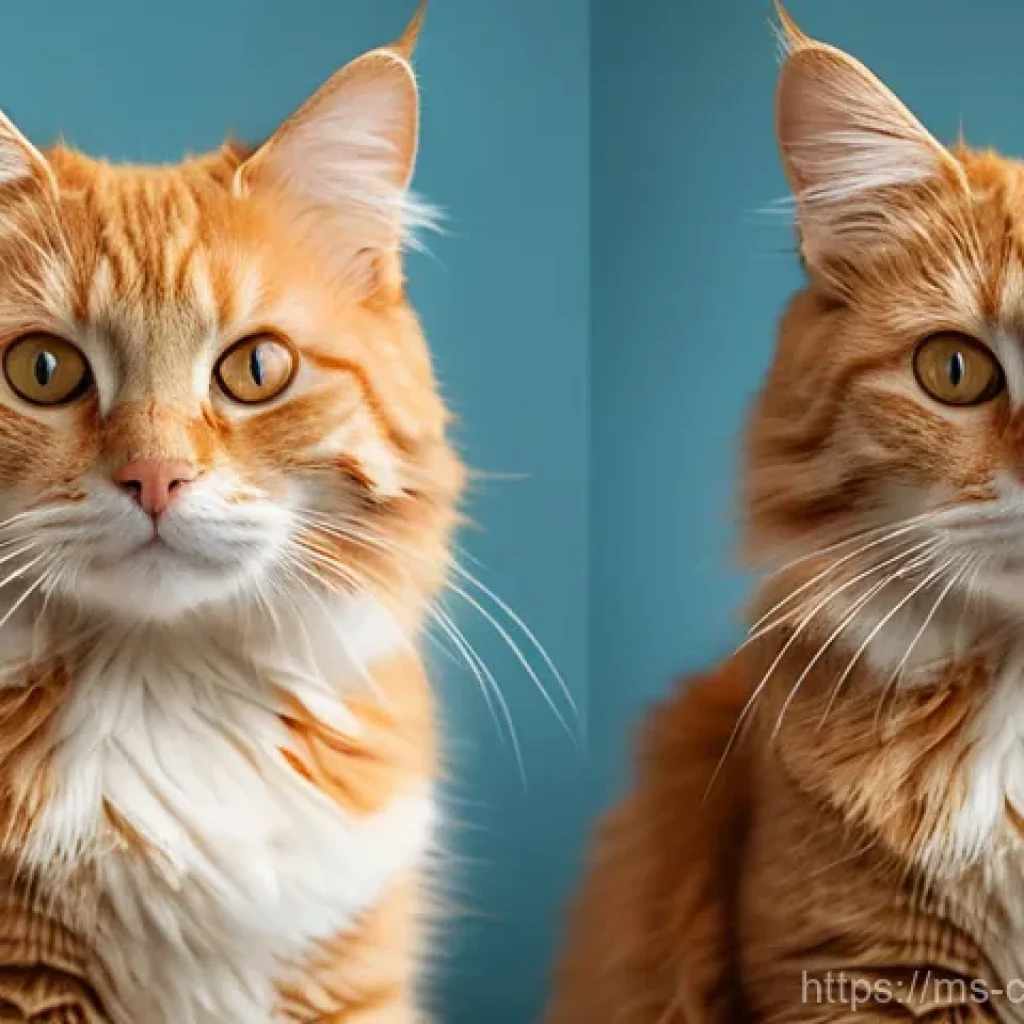

Macam mana nak suruh AI tu jadi pakar kalau dia cuma nampak beberapa contoh saja? Logik dia mudah, makin banyak contoh atau situasi yang AI tu ‘lihat’ semasa proses latihan, makin bagus dia faham corak dan buat generalisasi. Cuba bayangkan, kalau kita nak ajar AI kenal gambar kucing, tapi kita cuma tunjuk 10 gambar kucing je. Bila tiba-tiba dia nampak kucing spesis lain atau dari sudut yang berbeza, mesti dia blur kan? Ini yang kita panggil overfitting, di mana model AI tu jadi terlalu ‘ingat’ data latihan dia sampai tak boleh nak generalise pada data baru. Kalau ini berlaku, memang sia-sia la semua usaha kita. Jadi, kuantiti data tu sangat krusial untuk memastikan AI kita robust dan boleh adapt dengan pelbagai input yang tak pernah dia nampak sebelum ni. Dan percayalah, ini memang kunci utama untuk buat AI yang betul-betul berguna dalam dunia sebenar, bukan sekadar di teori.

Bukan Sekadar Banyak, Tapi Data Kualiti Pun Kena Jaga Baik-Baik

Ah, ini satu lagi point penting yang ramai terlepas pandang. Bukan main banyak je data tu, tapi kena tengok kualiti dia juga. Ibarat kita nak masak, tak guna kalau banyak sangat bahan tapi semua dah basi atau rosak. Data yang ada noise, tak konsisten, atau tak dilabel dengan betul boleh buat model AI kita jadi ‘sesat’. Pengalaman saya, pernah sekali saya guna data yang ada banyak missing values dan error. Hasilnya? Model AI saya buat ramalan yang sangat mengarut. Memang buang masa dan tenaga je. Jadi, walau kita nak ‘gemukkan’ data, pastikan asas data asal kita tu dah bersih dan berkualiti. Data augmentation ni memang bantu, tapi dia tak boleh repair data yang memang dah teruk dari awal. Jadi, langkah pertama, sentiasa bersihkan dan saring data korang sebelum buat apa-apa. Ini adalah asas paling penting dalam mana-mana projek AI, dan kalau tak jaga kualiti, memang tak ke mana la kita.

Strategi Ajaib: Ubah Data Biasa Jadi ‘Luar Biasa’ Dengan Data Augmentation

Macam yang saya dah hint tadi, ada satu ‘senjata rahsia’ yang pakar AI selalu guna untuk atasi masalah kekurangan data ni, iaitu Data Augmentation. Bunyi macam canggih, tapi konsep dia sebenarnya mudah je. Bayangkan korang ada sebiji epal. Dengan data augmentation, kita boleh ‘pusing-pusingkan’ epal tu, ‘besarkan’ atau ‘kecilkan’ sikit, ‘gelapkan’ atau ‘cerahkan’ warnanya, atau potong separuh. Hasilnya? Dari sebiji epal, kita dah ada banyak versi epal yang berbeza tapi masih dikenali sebagai epal. Ini yang membuatkan model AI kita jadi lebih pintar sebab dia belajar dari pelbagai variasi yang ada, walaupun semuanya berasal dari data asal yang sama. Saya sendiri pernah guna teknik ni untuk projek pengenalan objek, dan hasilnya memang jauh lebih baik berbanding tak guna langsung. Model AI saya jadi lebih resilient dan tak mudah salah kenal objek walaupun dalam keadaan pencahayaan atau sudut pandang yang berbeza. Ini memang game changer!

Kembangkan Koleksi Data Tanpa Perlu Kumpul Yang Baru

Kelebihan paling ketara data augmentation ni adalah kita tak perlu pecah kepala atau keluarkan duit banyak-banyak untuk kumpul data baru. Kumpul data ni bukan kerja mudah tau, kadang kena buat survey, ambil gambar beribu-ribu, atau upah orang labelkan. Semua tu makan kos dan masa. Dengan data augmentation, kita guna apa yang ada, cuma kita ‘manipulasi’ data tu sikit-sikit. Bagi gambar, kita boleh flip, rotate, zoom, atau tambah noise. Kalau data teks pula, kita boleh tukar sinonim, tukar struktur ayat, atau buang/tambah perkataan. Kan dah jimat banyak kat situ? Saya sendiri sebagai pemilik blog, masa adalah emas. Kalau boleh jimat masa kat sini, saya boleh fokus pada benda lain yang lebih penting. Ia seperti ada mesin ajaib yang boleh gandakan data kita tanpa sebarang kos tambahan. Ini memang rezeki untuk sesiapa yang ada kekangan sumber dan masa.

Tingkatkan ‘Kebal’ Model AI Terhadap Variasi Data

Model AI yang dilatih dengan data yang pelbagai hasil dari augmentation ni akan jadi lebih ‘kebal’ atau robust. Maksudnya, dia tak mudah goyah bila berhadapan dengan data yang ada sedikit perbezaan dari apa yang dia dah belajar. Sebagai contoh, dalam sistem pengecaman wajah, kalau kita cuma latih AI dengan gambar yang jelas dan terang, bila tiba-tiba dia kena kenal wajah yang samar-samar atau kurang cahaya, dia mungkin gagal. Tapi, kalau kita dah buat augmentation dengan pelbagai efek cahaya dan blur, model kita akan lebih bersedia. Ini adalah pengalaman saya sendiri bila saya buat projek pengenalan tulisan tangan. Dengan augmentasi, model saya boleh kenal tulisan tangan walaupun gaya penulisan tu berbeza-beza antara individu. Memang tak sangka, efek kecil dari augmentation ni boleh beri impak sebesar itu pada prestasi model.

Teknik-Teknik Rahsia Yang Saya Sendiri Guna Untuk ‘Gemukkan’ Data

Baiklah, sekarang tiba masa untuk saya kongsi teknik-teknik yang saya sendiri dah cuba dan terbukti berkesan untuk buat data kita jadi lebih ‘kaya’. Ini bukan teori semata-mata tau, tapi memang based on pengalaman saya. Ada banyak cara, tapi saya akan fokus pada yang paling popular dan mudah nak apply, terutamanya untuk data imej dan teks. Jangan risau, tak perlu jadi pakar coding pun untuk faham konsep ni. Anggap je kita ni macam tukang masak yang nak tambah perasa pada hidangan supaya jadi lebih sedap dan menarik. Dengan teknik-teknik ni, korang boleh nampak sendiri perubahan pada prestasi model AI korang. Saya jamin, bila dah cuba, korang takkan pandang rendah pada kuasa data augmentation ni lagi. Kadang-kadang, perubahan kecil pun boleh datangkan impak yang sangat besar pada keseluruhan projek.

Main Dengan Gambar: Dari Flip Sampai Warna

Untuk data imej, teknik augmentation ni memang sangat versatile. Antara yang paling asas dan senang nak buat adalah:

- Horizontal/Vertical Flip: Macam kita belek gambar kat galeri phone, kita flip je gambar tu secara mendatar atau menegak. Mudah kan?

- Rotation: Pusingkan gambar sikit, mungkin 5 darjah, 10 darjah, atau 15 darjah ke kiri atau kanan. Ini bantu model kenal objek dari pelbagai sudut.

- Zoom In/Out: Kita besarkan atau kecilkan sikit gambar tu. Ini penting sebab dalam dunia sebenar, objek boleh muncul pada saiz yang berbeza-beza.

- Brightness/Contrast Adjustment: Ubah kecerahan atau kontras gambar. Ini sangat membantu untuk buat model tahan lasak pada perubahan cahaya.

- Adding Noise: Tambah sikit ‘gangguan’ pada gambar, macam bintik-bintik putih. Ini boleh simulate gambar yang kurang jelas.

Saya sendiri pernah guna teknik ni untuk projek pengenalan penyakit pada daun tanaman. Dengan pelbagai variasi gambar daun yang di-augment, model saya boleh kenal penyakit tu dengan lebih tepat, walaupun gambar yang saya ambil tu dalam keadaan cahaya yang berbeza atau dari sudut yang pelik-pelik. Memang jimat masa saya dari kumpul gambar daun yang sakit satu per satu.

Kreatif Dengan Teks: Ubah Ayat, Kekalkan Maksud

Bila cerita pasal data teks pula, augmentation ni sedikit tricky tapi masih sangat berguna. Kita tak boleh main sesuka hati tukar perkataan nanti maksud dia lari. Jadi, teknik-teknik yang biasa saya guna termasuklah:

- Synonym Replacement: Tukar perkataan dengan sinonimnya. Contohnya, ‘gembira’ tukar kepada ‘bahagia’. Tapi kena hati-hati, tak semua sinonim sesuai dalam konteks tertentu.

- Random Insertion/Deletion/Swap: Kita masukkan perkataan rawak, buang perkataan, atau tukar posisi perkataan dalam ayat. Tapi kena pastikan struktur ayat dan maksud asal tak terjejas teruk.

- Back Translation: Ini teknik yang agak canggih. Kita terjemahkan teks ke bahasa lain, kemudian terjemah balik ke bahasa asal kita. Kadang-kadang, proses ni boleh hasilkan variasi ayat yang masih kekal maksudnya.

Saya pernah apply back translation ni untuk data ulasan pelanggan dalam Bahasa Melayu. Dengan terjemahan ke Bahasa Inggeris kemudian ke Bahasa Melayu semula, saya dapat pelbagai versi ayat yang sama makna. Ini sangat membantu model analisis sentimen saya untuk lebih faham nuansa bahasa kita. Memang terbukti berkesan untuk buat model jadi lebih ‘sensitif’ terhadap emosi dalam teks.

Silap Mata Biasa Semasa Buat Data Augmentation: Elakkan Kalau Tak Nak Menyesal!

Walaupun data augmentation ni nampak macam magic, tapi jangan ingat tak ada cabaran atau perangkap yang boleh buat kita tersilap langkah. Pengalaman saya, banyak je kali saya buat kesilapan masa mula-mula dulu, sampai model AI saya jadi lagi teruk! Jadi, saya tak nak korang pun lalui benda yang sama. Ada beberapa ‘silap mata’ atau kesilapan biasa yang perlu korang elakkan kalau tak nak menyesal di kemudian hari. Jangan terkejut kalau saya cakap, kadang-kadang niat kita nak bagi data tu ‘kaya’, tapi tersalah buat, data tu jadi ‘racun’ pula pada model AI kita. Penting untuk faham, walaupun kita nak hasilkan variasi, variasi tu mestilah masih logik dan masuk akal dalam konteks masalah yang kita nak selesaikan. Kalau tak, memang jadi kerja sia-sia la.

Terlebih Guna Sampai Data Jadi Tak Realistik

Ini adalah kesilapan paling utama yang ramai buat. Terlalu ghairah nak hasilkan banyak data sampai kita guna teknik augmentation yang keterlaluan. Contohnya, kalau kita buat flip gambar kucing secara menegak, jadinya kucing tu terbalik! Walaupun kita tahu itu masih kucing, tapi dalam realiti, kucing takkan muncul secara terbalik begitu. Ini boleh confuse model kita. Atau, kita ubah kecerahan gambar sampai objek tu tak nampak langsung. Kalau data augmentasi yang kita hasilkan tu tak realistik atau tak logik dalam konteks dunia sebenar, ia boleh buat model kita belajar benda yang salah dan kurang berkesan bila berhadapan dengan data sebenar. Kena ada kawalan, jangan main hentam saja. Kena fikir, adakah variasi yang kita hasilkan ni masih relevan dan boleh berlaku dalam keadaan sebenar? Kalau jawapannya tidak, kurangkan atau jangan guna teknik tu.

Lupa Nak Validate Data Augmentation

Satu lagi kesilapan yang saya pernah buat dan saya tak nak korang ulang, adalah lupa nak validate atau periksa data yang dah di-augment. Kita buat augmentation secara automatik, lepas tu terus bagi pada model untuk latihan. Ini bahaya! Kadang-kadang, teknik augmentation yang kita guna tu ada bug, atau tak sesuai dengan jenis data kita, tapi kita tak perasan. Akibatnya, data yang terhasil jadi rosak atau tak berguna. Selepas buat augmentation, luangkan sedikit masa untuk tengok sample data yang dah diubah tu. Pastikan ia masih relevan dan kualiti dia masih baik. Macam kita masak, dah bubuh perasa, kena la rasa sikit kan? Sama juga dengan data. Ini langkah penting yang boleh elakkan kita dari buang masa latih model dengan data yang tak valid, dan boleh menyelamatkan projek korang dari kegagalan.

Manfaat Besar Data Augmentation Untuk Bisnes Kecil di Malaysia

Korang tahu tak, teknik data augmentation ni bukan saja untuk syarikat besar yang ada berjuta-juta data. Sebenarnya, bisnes kecil dan sederhana (PKS) di Malaysia lah yang paling banyak boleh dapat manfaat dari teknik ni! Kenapa saya cakap macam tu? Sebab PKS selalunya ada kekangan modal dan sumber untuk kumpul data yang besar. Nak upah team data scientist atau beli dataset beribu-ribu ringgit tu memang bukan pilihan. Tapi, dengan data augmentation, kita boleh buatkan data sedia ada jadi lebih ‘kaya’ tanpa perlu belanja besar. Ini adalah peluang keemasan untuk PKS di Malaysia untuk bersaing dalam era digitalisasi ni. Saya sendiri sebagai pemilik blog, saya faham sangat cabaran nak maintain kos. Jadi, apa saja yang boleh jimatkan kos tapi bagi impak besar, saya akan cuba terokai.

Jimat Kos dan Masa Untuk Kumpul Data

Ini memang poin paling utama untuk PKS. Bayangkan, kalau korang nak buat sistem pengenalan produk untuk kedai online korang, tapi cuma ada beberapa ratus gambar produk. Nak ambil gambar baru untuk setiap angle dan setiap keadaan cahaya memang makan masa dan kos. Dengan data augmentation, korang boleh hasilkan beribu-ribu variasi gambar dari ratusan gambar asal tu je. Ini dah jimatkan banyak kos photographer, studio, dan masa untuk labelkan gambar. Dengan kos yang minimal, PKS boleh bangunkan model AI yang cukup baik untuk kegunaan dalaman atau untuk tingkatkan pengalaman pelanggan. Sebagai contoh, syarikat yang nak buat chatbot untuk support pelanggan boleh gunakan augmentation untuk data perbualan, supaya chatbot lebih faham pelbagai jenis soalan dari pelanggan.

Tingkatkan Daya Saing Dengan Teknologi AI

Dulu, teknologi AI ni macam eksklusif untuk syarikat gergasi saja. Tapi sekarang, dengan teknik macam data augmentation, PKS pun boleh celik AI. Dengan model AI yang lebih baik, PKS boleh tingkatkan efisiensi operasi, buat keputusan yang lebih tepat berdasarkan data, dan tawarkan produk atau servis yang lebih inovatif. Contohnya, kedai bunga boleh guna AI untuk ramal trend jualan bunga berdasarkan cuaca dan musim, atau kedai makan boleh guna AI untuk optimize inventori bahan mentah. Ini semua boleh dilakukan dengan data yang terhad, asalkan kita tahu cara ‘gemukkan’ dia. Jadi, jangan rasa ketinggalan, PKS Malaysia boleh dan patut guna peluang ni untuk melonjakkan perniagaan ke tahap seterusnya. Percayalah, AI ni bukan lagi hanya untuk golongan elit, tapi untuk semua.

Alat-Alat Power Untuk Data Augmentation Yang Wajib Korang Tahu

Sekarang, dah faham konsep dan kenapa data augmentation ni penting, mesti korang nak tahu kan, alat apa yang kita boleh guna untuk buat semua ni? Jangan risau, ada banyak alat dan perpustakaan (libraries) yang memang power dan mudah digunakan, walaupun korang bukan pro dalam coding. Ada yang open-source dan percuma, ada juga yang berbayar tapi offer lebih banyak features. Saya dah cuba beberapa, dan ada yang memang jadi pilihan utama saya. Alat-alat ni lah yang akan memudahkan kerja kita, jadi kita tak perlu nak tulis kod dari awal untuk setiap proses augmentation. Ini memang sangat membantu, terutamanya untuk kita yang baru nak berjinak-jinak dengan dunia AI ni. Dengan adanya alat ni, proses augmentation jadi lebih cepat dan efisien.

Perpustakaan Python Pilihan Ramai (Keras, PyTorch, Albumentations)

Kalau korang ada asas coding Python, memang senang gila nak guna perpustakaan ni:

- Keras/TensorFlow: Untuk data imej, Keras ada ImageDataGenerator yang sangat popular. Senang nak guna untuk apply pelbagai transformasi macam rotate, zoom, shift, dan flip. Ini biasanya built-in dalam kebanyakan framework deep learning.

- PyTorch: PyTorch pun ada torchvision.transforms yang berfungsi sama. Ia menawarkan fleksibiliti yang tinggi untuk apply transformasi pada data imej korang. Saya sendiri sering guna ini untuk projek-projek yang lebih kompleks.

- Albumentations: Ini adalah perpustakaan khusus untuk augmentation imej yang sangat laju dan offer banyak transformasi yang advanced. Kalau korang serius dalam computer vision, ini memang wajib ada dalam toolbox korang. Pengalaman saya, Albumentations ni memang jimat masa sebab kod dia ringkas tapi powerful.

Untuk data teks pula, biasanya kita kena buat custom function sikit atau guna perpustakaan macam NLTK atau spaCy untuk proses tukar sinonim atau back translation. Ada juga library macam nlpaug yang memang direka khas untuk text augmentation.

Platform Online Atau Perisian No-Code Untuk Yang Tak Coding

Untuk korang yang tak berapa gemar coding atau tak ada masa nak belajar, jangan risau! Ada juga platform online atau perisian no-code yang boleh bantu buat data augmentation:

- Augment AI Tools: Ada beberapa platform online yang menawarkan servis data augmentation sebagai perkhidmatan. Korang upload data, pilih teknik augmentation, dan mereka akan generate data yang baru untuk korang.

- Commercial AI Platforms: Sesetengah platform AI berbayar macam Google Cloud AI Platform atau AWS SageMaker ada built-in function untuk data augmentation yang korang boleh guna tanpa perlu coding yang banyak.

Pilihan ni sangat bagus untuk PKS yang mungkin tak ada pakar IT atau data scientist dalam team. Ia membolehkan korang manfaatkan kuasa AI tanpa perlu melabur besar dalam pembangunan skill coding. Bagi saya, apa saja cara yang memudahkan kerja, itu lah yang terbaik.

Masa Depan Data Augmentation: Apa Yang Korang Perlu Bersedia?

Dunia AI ni bergerak sangat pantas, dan teknik data augmentation pun sama. Apa yang kita guna hari ni, mungkin akan ada versi yang lebih canggih esok. Jadi, sebagai penggemar AI (dan saya tahu ramai di antara korang pun sama), kita kena sentiasa peka dan bersedia dengan trend dan inovasi terbaru dalam bidang ni. Jangan sampai kita jadi ketinggalan, sebab teknologi ni boleh beri kelebihan kompetitif yang sangat besar. Saya selalu cuba untuk baca artikel-artikel terkini dan join webinar untuk update diri. Ini penting kalau kita nak pastikan projek AI kita sentiasa relevan dan berdaya saing. Saya percaya, data augmentation akan terus jadi tulang belakang kepada pembangunan AI di masa hadapan, terutamanya bila berhadapan dengan data-data yang sensitif atau sukar dikumpul.

Automasi dan Augmentation Berdasarkan Model (Model-Based Augmentation)

Trend yang paling menarik saya perhatikan adalah ke arah automasi. Bayangkan, satu hari nanti, sistem AI tu sendiri yang akan tentukan teknik augmentation terbaik untuk data kita, dan buat secara automatik! Ini memang akan jimatkan banyak masa dan usaha. Selain tu, ada juga apa yang dipanggil sebagai Model-Based Augmentation. Maksudnya, model AI tu akan belajar cara untuk generate data baru yang realistik berdasarkan data asal. Teknik Generative Adversarial Networks (GANs) adalah contoh terbaik untuk ini. Ia boleh hasilkan data imej atau teks yang sangat menyerupai data sebenar, sehingga sukar nak beza. Ini memang satu lompatan besar dalam dunia augmentation. Saya sendiri tak sabar nak tengok teknologi ni jadi lebih matang dan mudah diakses oleh semua.

Data Augmentation Untuk Jenis Data Baru (Audio, Video, 3D)

Setakat ni, kita banyak cerita pasal imej dan teks kan? Tapi sebenarnya, data augmentation juga dah mula berkembang pesat untuk jenis data lain seperti audio (bunyi), video, dan data 3D. Contohnya, untuk data audio, kita boleh ubah pitch, kelajuan, atau tambah noise pada audio asal untuk hasilkan variasi. Untuk video pula, kita boleh ubah frame rate, tambah efek cahaya, atau pusingkan angle kamera. Ini sangat berguna untuk aplikasi seperti pengenalan pertuturan atau analisis video. Dalam bidang realiti maya (VR) dan realiti terimbuh (AR), data augmentation untuk model 3D juga semakin penting. Jadi, korang kena bersedia untuk melihat lebih banyak inovasi dalam area ni. Ia akan membuka lebih banyak pintu untuk aplikasi AI yang lebih luas dan menarik di masa hadapan. Memang satu perkembangan yang sangat exciting untuk diperhatikan.

Sebagai rujukan ringkas, saya ada sediakan satu jadual perbandingan teknik data augmentation popular:

| Jenis Data | Teknik Augmentation Utama | Contoh Penerangan | Kelebihan |

|---|---|---|---|

| Imej | Flip (Horizontal/Vertical) | Membalikkan gambar secara mendatar atau menegak. | Mudah, kekalkan ciri objek. |

| Imej | Rotation | Memutarkan gambar pada sudut tertentu. | Model lebih tahan lasak pada perubahan orientasi. |

| Imej | Brightness/Contrast Adjustment | Mengubah kecerahan atau kontras gambar. | Model lebih baik dalam pelbagai keadaan pencahayaan. |

| Teks | Synonym Replacement | Menggantikan perkataan dengan sinonimnya. | Meningkatkan pemahaman model terhadap variasi bahasa. |

| Teks | Back Translation | Terjemah ke bahasa lain, kemudian terjemah balik ke bahasa asal. | Menghasilkan variasi ayat yang sama makna. |

| Teks | Random Insertion/Deletion | Menambah atau membuang perkataan secara rawak. | Meningkatkan keupayaan model memahami ayat tidak sempurna. |

글을 마치며

Nampaknya kita dah sampai ke penghujung perkongsian saya kali ini! Saya harap sangat apa yang saya kongsikan tentang data augmentation ni dapat buka mata korang, terutamanya untuk para usahawan PKS di Malaysia yang berani nak terokai dunia AI. Jangan pernah rasa putus asa bila berhadapan dengan data yang terhad, sebab selalu ada jalan penyelesaian yang kreatif dan berkesan. Ingat, kunci utama bukan hanya pada kuantiti data, tapi bagaimana kita bijak menguruskannya. Dengan data augmentation, korang dah ada satu ‘kuasa’ rahsia untuk jadikan model AI korang lebih pintar dan berdaya saing. Saya sendiri dah cuba, dan memang tak sangka impak dia sangat positif. Jadi, jangan tunggu lagi, jom kita sama-sama ‘gemukkan’ data kita!

알아두면 쓸모 있는 정보

1. Mulakan Dengan Data Asal Yang Berkualiti

Percayalah, tak guna kita nak buat data augmentation kalau data asal kita dah memang bermasalah. Ibarat kita nak buat kopi, tak guna kalau biji kopi tu dah busuk dari awal. Jadi, sebelum fikir nak ‘gemukkan’ data, pastikan korang dah luangkan masa yang cukup untuk membersihkan, menyaring, dan melabelkan data asal korang dengan betul. Buang data yang ada noise, isi tempat kosong (missing values), dan pastikan konsistensi data tu terjaga. Ini adalah asas paling penting untuk memastikan proses augmentation nanti memberi hasil yang positif dan bukannya sebaliknya. Saya sendiri pernah terburu-buru dan hasilnya model AI jadi merapu. Jadi, jangan ulangi kesilapan saya ya! Fikirkan ia sebagai membina pondasi yang kukuh sebelum mendirikan bangunan tinggi, kalau pondasi tak kuat, tak lama bangunan tu akan runtuh.

2. Pilih Teknik Augmentation Yang Sesuai

Bukan semua teknik augmentation sesuai untuk semua jenis data atau semua masalah. Ada banyak teknik di luar sana, dari yang paling asas sampai yang paling canggih. Korang kena bijak memilih teknik yang paling relevan dengan domain data korang. Contohnya, untuk data imej perubatan, mungkin korang tak boleh main flip gambar sesuka hati sebab ia boleh mengubah maksud klinikal gambar tersebut. Begitu juga dengan data teks yang sensitif, kena hati-hati bila tukar sinonim supaya maksud asal tak terjejas. Luangkan masa untuk kaji dan fahamkan teknik-teknik yang ada, dan buat eksperimen kecil-kecilan untuk tengok mana yang paling berkesan. Jangan takut mencuba, tapi sentiasa fikirkan logiknya. Ini akan bantu korang dapatkan hasil terbaik tanpa membazir masa.

3. Validasi Data Yang Telah Diaugmentasi

Jangan sesekali terus guna data yang dah diaugmentasi tanpa semak dan periksa. Ini adalah ‘perangkap’ yang ramai orang baru dalam bidang AI selalu jatuh. Selepas proses augmentation selesai, ambil masa untuk lihat sample data yang dah terhasil. Adakah ia masih realistik? Adakah labelnya masih betul? Adakah ia benar-benar menambah variasi yang berguna? Kalau data imej, tengoklah adakah gambar tu jadi pelik atau tak logik. Kalau data teks, baca balik adakah ayat tu masih ada makna. Langkah validasi ni sangat penting untuk elakkan kita latih model AI dengan data yang rosak atau tak relevan. Pengalaman saya, langkah kecil ni boleh selamatkan korang dari berhari-hari kerja keras yang sia-sia. Anggap ia sebagai ‘quality control’ sebelum hantar produk ke pasaran.

4. Jangan Keterlaluan Dalam Augmentation

Ini sambungan dari poin validasi tadi. Niat kita memang nak hasilkan banyak data, tapi jangan sampai terlebih dos. Kalau kita buat augmentation secara ekstrem, sampai data yang terhasil tu jadi tak realistik atau tak pernah berlaku dalam dunia sebenar, ia boleh buat model AI kita jadi ‘keliru’ dan tak berfungsi dengan baik bila berhadapan dengan data sebenar nanti. Contohnya, mengubah kecerahan gambar sehingga objek tak nampak, atau memutar imej sehingga orientasi objek jadi terbalik sepenuhnya. Kena ada batasnya. Matlamat kita adalah untuk meniru variasi semulajadi yang mungkin berlaku dalam data, bukan mencipta data yang mustahil. Ingat, kesederhanaan itu lebih baik dalam banyak perkara, termasuklah dalam data augmentation. Sentiasa seimbangkan antara kuantiti dan kualiti.

5. Manfaatkan Sumber Pembelajaran Dan Komuniti

Dunia AI dan data science ni sangat besar dan sentiasa berkembang. Korang tak perlu jadi pakar seorang diri. Manfaatkan sumber pembelajaran online seperti kursus percuma, tutorial blog, atau video YouTube yang ada banyak di luar sana. Selain tu, jangan malu untuk sertai komuniti AI di Malaysia atau di peringkat global. Korang boleh tanya soalan, kongsi pengalaman, dan belajar dari orang lain. Ada banyak kumpulan Facebook atau forum online yang aktif membincangkan topik-topik berkaitan AI. Saya sendiri banyak belajar dari komuniti. Ini bukan saja bantu korang selesaikan masalah, tapi juga dapat buka peluang untuk berkolaborasi dan kembangkan rangkaian korang. Jadi, jangan bersendirian, sentiasa libatkan diri dan belajar daripada orang lain. Ilmu dikongsi, manfaatnya berlipat kali ganda.

중요 사항 정리

Secara ringkasnya, data augmentation adalah satu ‘senjata rahsia’ yang sangat ampuh untuk mengatasi masalah kekurangan data berkualiti dalam pembangunan model AI kita. Ia membolehkan kita ‘mengembangkan’ set data sedia ada kepada variasi yang lebih banyak dan pelbagai tanpa perlu mengumpul data baru yang mahal dan memakan masa. Dengan teknik-teknik seperti flipping, rotation, adjustment kecerahan untuk imej, atau penggantian sinonim dan terjemahan balik untuk teks, model AI kita akan menjadi lebih robust, kurang terdedah kepada overfitting, dan mampu membuat ramalan yang lebih tepat dalam pelbagai senario dunia sebenar. Ini sangat relevan untuk PKS di Malaysia yang mungkin mempunyai kekangan sumber, membolehkan mereka bersaing dengan teknologi AI yang canggih dengan kos yang lebih rendah. Namun, penting untuk sentiasa berhati-hati agar tidak keterlaluan dalam augmentation dan sentiasa melakukan validasi untuk memastikan data yang terhasil kekal realistik dan berkualiti. Menggunakan perpustakaan Python seperti Keras atau Albumentations, serta platform no-code, boleh memudahkan proses ini. Masa depan data augmentation akan lebih ke arah automasi dan penghasilan data yang lebih kompleks, jadi sentiasa bersedia untuk belajar dan adaptasi dengan teknologi terkini demi memastikan projek AI korang sentiasa relevan dan berjaya.

Soalan Lazim (FAQ) 📖

S: Apakah ‘rahsia’ yang anda maksudkan untuk mengatasi masalah kekurangan data dalam projek AI?

J: Wah, soalan ni memang ramai yang tertanya-tanya! ‘Rahsia’ yang saya maksudkan ni sebenarnya adalah teknik yang dikenali sebagai Data Augmentation atau dalam Bahasa Melayunya, Peningkatan Data.

Bunyi macam canggih, tapi konsepnya mudah saja. Bayangkan, kalau kita ada gambar kucing, kita boleh ubah suai sikit gambar tu—pusingkan ke kiri, ke kanan, terbalikkan, adjust kecerahan, atau potong sikit bahagiannya—tapi ia masih lagi gambar kucing.

Dengan cara ni, dari satu gambar kucing, kita dapat hasilkan banyak ‘versi baru’ gambar kucing yang berbeza-beza, tanpa perlu ambil gambar baru pun! Model AI kita akan nampak semua versi ni sebagai data baru dan akan belajar dengan lebih mendalam.

Saya sendiri terkejut bila pertama kali cuba, model yang saya latih jadi jauh lebih pandai kenal objek walaupun guna data asal yang sikit. Memang sangat membantu untuk projek-projek AI yang sensitif seperti pengecaman wajah atau objek.

S: Bagaimana pula teknik peningkatan data ini boleh membantu PKS di Malaysia atau individu yang ada data terhad?

J: Ini poin paling penting yang saya nak tekankan! Untuk PKS (Perusahaan Kecil dan Sederhana) di Malaysia, atau pun mana-mana individu yang mungkin baru nak berjinak dengan AI tapi tak ada bajet besar untuk kumpul data, Data Augmentation ni ibarat penyelamat.

Kebanyakan PKS kita mungkin ada data pelanggan atau jualan yang terhad. Kalau nak latih AI untuk buat ramalan atau klasifikasi, data yang sikit sangat berisiko membuat model kita ‘overfit’—maksudnya, dia pandai sangat dengan data yang dia dah nampak, tapi bila dapat data baru, terus gagal.

Dengan teknik ni, kita boleh ‘kembangkan’ set data yang sedia ada tu, jadikan model AI kita lebih lasak dan pandai buat generalisasi. Ini bermakna, PKS boleh bangunkan solusi AI yang efektif tanpa perlu melabur besar dalam pengumpulan data.

Contohnya, kalau ada butik baju online yang nak AI klasifikasi jenis baju dari gambar, tapi gambar produk tak banyak, teknik ni boleh hasilkan lebih banyak variasi gambar baju untuk latihan AI.

Ini dapat kurangkan kos dan masa, yang mana PKS sangat perlukan untuk terus berdaya saing dalam pasaran digital yang mencabar hari ini.

S: Boleh tak berikan contoh spesifik jenis data yang paling sesuai dan berkesan dengan teknik Data Augmentation, terutama dalam konteks tempatan kita?

J: Sudah tentu! Dalam pengalaman saya, Data Augmentation ni memang serba boleh, tapi ada beberapa jenis data yang paling ketara keberkesanannya. Yang pertama, dan paling popular, adalah data gambar atau imej.

Macam contoh gambar kucing tadi, ini sangat relevan untuk industri seperti e-dagang tempatan yang nak AI kenal pasti produk dari gambar, atau dalam sektor pertanian untuk kenal pasti jenis tanaman atau penyakit.

Kedua, data teks. Kita boleh ubah sikit struktur ayat, tukar perkataan dengan sinonim, atau ubah susunan ayat tanpa mengubah maksud asal. Ini berguna untuk chatbot layanan pelanggan PKS yang nak AI faham pelbagai cara pelanggan bertanya soalan, atau untuk analisis sentimen bagi produk makanan tempatan kita.

Ketiga, data audio. Kita boleh tambahkan noise yang ringan, tukar pitch suara, atau ubah kelajuan. Ini sesuai untuk aplikasi pengecaman suara dalam Bahasa Melayu yang mungkin ada pelbagai dialek dan intonasi.

Saya pernah cuba dengan data resit-resit kedai makan tempatan untuk latih AI kenal pasti item, dan dengan sedikit peningkatan data, model AI saya jadi jauh lebih tepat dalam mengesan nama hidangan dari pelbagai jenis resit.

Pendek kata, teknik ni sangat membantu untuk data yang berbentuk tidak berstruktur dan perlukan variasi yang tinggi.